REINCANTAMENTO. Episodio 9. Guardare la sproporzione

Bentornate, bentornati su REINCANTAMENTO. Finalmente, ritorniamo in questo spazio dopo un periodo troppo lungo di assenza. REINCANTAMENTO però in questo autunno non si è fermato: ho partecipato all’inaugurazione di Fondo, uno spazio artistico e curatoriale a Torino. In parte poi, la nostra riflessione è proseguita per frammenti sulla pagina Instagram, dove ho cercato di riportare cronache, opere d’arte e altro ancora per raccontare più concretamente il grande campo di forze delle tecnologie digitali e i due poli che lo animano: l’apertura magica e la chiusura tecnica. In questa puntata tenteremo di unire alcune di queste tracce.

Gli alieni, la sproporzione e noi

Nella trilogia dei Tre Corpi, una delle migliori opere di fantascienza del XXI secolo, lo scrittore cinese Liu Cixin descrive il primo contatto dell’umanità con una razza aliena. Una delle tante sensazioni che Cixin riesce a trasmettere in modo magistrale è l’incomprensibilità: quello strano sentore che ci pervade quando ci troviamo di fronte all’Altro, al radicalmente diverso. Nei romanzi di Cixin questo feeling emerge davanti alla razza aliena di Trisolaris, che ragiona in un modo impensabile e impenetrabile per i nostri occhi umani. Ma non vogliamo parlare a lungo della trilogia dei Tre Corpi: prenderemo in prestito soltanto questo gelido brivido perturbante provato dalla razza umana davanti ad uno sguardo così estraneo perché ci riporta a questioni già trattate nella nostra rubrica.

La complessità tecnologica spesso può restituirci una sensazione simile. E’ difficile rimanere neutrali davanti alle risposte di GPT-3, una IA specializzata nel linguaggio umano, che può intrattenere conversazioni profonde come una persona colta. Come racconta Marco Mattei in questo articolo, parlare con GPT-3 è un’esperienza disturbante, che può farci rabbrividire, come davanti agli alieni di Liu Cixin. Allo stesso modo, è difficile non impressionarsi davanti ad AlphaGo, l’ormai mitico software che gioca a Go, un antico gioco cinese, e che ha sconfitto con mosse imprevedibili tutti i campioni umani. Potremmo andare avanti con molti altri esempi che raccontano i progressi che le tecniche di apprendimento artificiale stanno raggiungendo nella nostra epoca.

La nostra società sogna da tanto tempo di poter riprodurre ed esternalizzare l’Intelligenza umana (per qualcuno, questo è addirittura lo scopo finale della filosofia): questa fantasia porta con sé miti di totale oggettività, di scelte neutrali, precise e ‘migliori per tutti’. L’autonomia della tecnica ci affascina e ci tormenta sin dai tempi di Prometeo L’immaginazione di registi e autori ha dato vita a tante incarnazioni dell’idea di Intelligenza Artificiale Generale ed è difficile non associare gli attuali sviluppi tecnici con i sogni (o gli incubi) del nostro inconscio culturale. Se ci fermassimo qui però, non staremo guardando abbastanza da vicino. Staremmo davvero credendo ad un gioco di prestigio.

Vogliamo chiamare incantamento illusorio questa rappresentazione mistificatoria e ideologica delle IA. Si tratta di un tipo di narrazione e significazione della tecnica opposta rispetto all’idea di reincantamento. Se reincantare la tecnologia vuol dire conoscerla, darle nuovi fini e nuovi mezzi; cedere all’incantamento illusorio significa invece fermarsi a quella patina superficiale e ideologica che si propaga dai nostri dispositivi fino alle parole dei grandi CEO californiani. L’incantamento illusorio della tecnologia è una strategia che finisce per alimentare le superstizioni, l’isteria o l’estremo ottimismo nei confronti dell’IA. Sia in caso di previsioni negative che di previsioni positive, finiamo per guardare al progresso tecnico come ad un grande e stupefacente Altro, di cui dobbiamo tradurre i pensieri e le volontà per prevedere il futuro. Per esempio, quando Elon Musk dice che il problema delle IA è la “più grande crisi esistenziale che l’umanità ha di fronte”, peggiore persino delle armi nucleari, sta alimentando una superstizione dai sapori hollywoodiani. Lo scienziato cognitivo — e noto critico musicale sul web — Piero Scaruffi ha rifiutato con decisione le affermazioni di Musk sui progressi delle IA in un’intervista su Pc Mag:

Prima di tutto, vorrei sapere di che “IA” stanno parlando. Se parlano di tecnologia in generale, allora benvenuti nel club. C’è una lunga storia che risale almeno agli anni ’60 di filosofi, sociologi, e così via, che mettevano in guardia l’umanità dal pericolo della tecnologia. Ci sono pericoli nel modo in cui utilizziamo la tecnologia, sia che si tratti di energia nucleare che di computer. Perché dovremmo preoccuparci più dell’IA che delle armi nucleari? O delle reti di computer molto convenzionali e molto stupide che controllano i mercati finanziari globali? L’IA che conosco è un campo di ricerca affascinante, un ramo della matematica computazionale [ma] purtroppo è ancora all’età della pietra.

Scaruffi si occupava di IA negli anni ’80 per Olivetti: un progetto che ha finito per sprecare molte risorse dell’azienda informatica italiana a causa della fase di stallo della ricerca in quel periodo. Riguardo alla fase in cui ci troviamo ora, Scaruffi dice:

I progressi nell’IA sono stati molto lenti e, recentemente, sono dovuti principalmente a tre fattori: Abbiamo finalmente dei set di dati molto grandi (ciò che serve per addestrare le reti neurali), Finalmente abbiamo processori molto veloci e convenienti (ciò di cui avete bisogno per eseguire reti neurali multistrato), Una delle principali società (la n. 1 o la n. 2 più apprezzata al mondo) ha fatto molto lavoro di PR per le IA

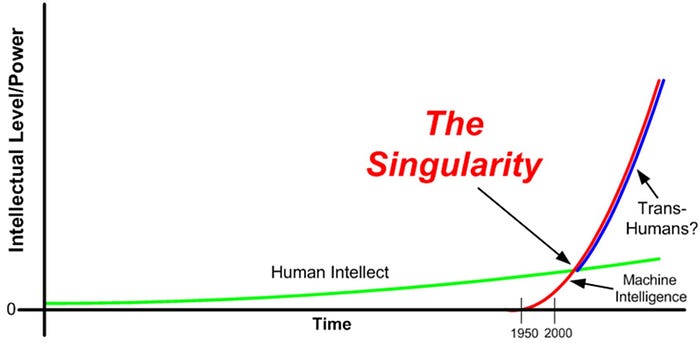

Musk non è solo. Anzi, studiosi rispettati come Max Tegmark o Nick Bostrom alimentano tali fantasie ma con sfumature più entusiastiche, parlando di prossime fusioni uomo-macchina e di una ventura “esplosione di intelligenza”. Un tale atteggiamento reverenziale, quasi mistico, verso i progressi tecnologici, non è altro che una storia che finisce per nascondere la vera natura, così drammaticamente umana, dei suoi problemi. Probabilmente il maggiore rappresentante di questa scuola di pensiero è Ray Kurzweil, inventore e informatico californiano, noto ai più per il concetto di Singolarità. L’idea di Singolarità di Kurzweil si riferisce ad un momento singolare nel futuro in cui la tecnologia svilupperà le capacità di comprensione dei suoi inventori: per Kurzweil si tratta del momento in cui le intelligenze artificiali diventeranno generali e supereranno il ragionamento umano. Nel corso degli anni, Kurzweil ha fatto molte previsioni: se ha previsto correttamente la vittoria di una macchina contro un campione di scacchi (il match del 1997 DeepBlue vs. Kasparov), ha fallito altrettante volte, per esempio ritenendo che l’economia americana sarebbe continuata a crescere ininterrottamente a partire dal boom delle aziende dot.com nel 1998.

Kurzweil crede che raggiungeremo un’IA di scopo generale e il momento di Singolarità intorno al 2045. Gran parte dell’argomentazione di Kurzweil si basa sull’idea di progresso esponenziale della tecnica e sulla nota prima legge di Moore, secondo cui “la complessità di un microcircuito, misurata ad esempio tramite il numero di transistor per chip, raddoppia ogni 18 mesi (e quadruplica quindi ogni 3 anni)”. La legge di Moore è stata dichiarata più volte “esaurita” e comunque il suo valore esplicativo non arrivava di certo a rendere scontata la realizzazione di un’intelligenza simil-umana (se non superiore).

Al di là dell’effettiva realizzazione della Singolarità (chi scrive è molto scettico), le idee di Kurzweil hanno un sapore messianico e la fiducia nella crescita esponenziale diventa qualcosa di molto simile ad una fede New Age. La Singolarità sembra configurare una palingenesi 2.0, un momento di rinascita e rinnovata armonia per l’umanità intera grazie al superamento dei limiti della tecnologia.

L’incantamento illusorio della tecnologia è un lavoro ideologico che opera una rappresentazione e un racconto dell’impresa tecnica nella direzione delle classi dominanti. Così, mentre la ricerca scientifica sulle IA è principalmente gestita da privati con sempre più scarsa trasparenza, si diffonde una vulgata distorta, che anticipa o progressi immediati e straordinari o paure al momento infondate. L’hype che circonda queste tecnologie è stato sviluppato ad arte, come ricordava Scaruffi, e deve essere mantenuto costante per non far calare il flusso di denaro verso i progetti di ricerca. Con questo gioco di prestigio, si eludono i rapporti di potere e di produzione che sottendono alla storia materiale delle Intelligenze Artificiali nella loro fase. L’illusione è l’opposto di quella riconquista della consapevolezza che abbiamo chiamato reincantamento. Il reincantamento è un lavoro di resistenza conoscitiva e di mutazione dell’intenzionalità collettiva: per arrivare a questi cambiamenti, occorre però scontrarsi e affrontare l’immagine distorta trasmessa dagli schermi del potere. Nonostante i sentimenti stranianti che ci suscitano, le IA non sono davvero delle misteriose creature aliene e pensanti piombate nel bel mezzo dei nostri salotti. Sono strumenti umani e la critica non può cedere al canto delle sirene.

Non dobbiamo dimenticare infatti che le fantasie e i dibattiti che circondano l’idea di General Artificial Intelligence arrivano quasi sempre da maschi, bianchi e occidentali, che proiettano su questo sogno tecnologico le proprie posizioni e i propri desideri. L’idea di General Artificial Intelligence proviene da un milieu culturale che unisce tecnologia, idee libertarie e neo-conservatorismo di stampo statunitense. Basti accennare come esempio al blogger Eliezer Yudkowsky, acceso seguace di Kurzweil, pseudo-ricercatore nel campo dell’IA e uber-razionalista, il cui principale merito consiste nell’aver convinto Peter Thiel, l’inventore di Paypal e supporter di Donald Trump, a finanziare i suoi progetti strampalati.

Per figure come Yudkowsky, il discorso sull’intelligenza artificiale si sposa con discorsi razziali sul valore del QI (secondo loro spesso più basso nelle persone non — bianche) e il suo forum LessWrong è servito come punto di incontro per le comunità della della alt-right americana. In questo humus trans-umanista e conservatore, esiste una storia che ci riporta ai nostri alieni, una storia che non nasconde neanche più le sfumature mistiche che il culto per la tecnologia produce. Stiamo parlando del Basilisco di Roko.

Roko era un utente del forum LessWrong che sconvolse gli altri poster con una sorta di esperimento mentale che parte da una domanda fondamentale: può esistere nel futuro un’intelligenza artificiale maligna che voglia punire coloro i quali non perseguono la sua creazione sin da oggi? Perché dovrebbe farlo? Secondo Roko, il Basilisco sarebbe all’inizio benevola e vorrebbe aiutare la specie umana. Essendo una superintelligenza le sua risorse saranno, da un punto di vista umano, illimitate e verranno spese per aiutare quante più persone possibili, anche quelle che il Basilisco non ha potuto salvare perché non esisteva. Quindi, non potendo tornare indietro nel tempo, il Basilisco vorrebbe, secondo la sua super-logica, accelerare la sua creazione. E come lo farebbe? Secondo la bizzarra teoria, lo farebbe condannando coloro che non hanno desiderato la sua creazione nel passato. Per cui, anche solo venendo a conoscenza del Basilisco di Roko, sarete condannati a subire la vendetta di questa super-intelligenza (mi dispiace).

Il Basilisco di Roko ricorda la celebre scommessa di Pascal. L’esistenza di Dio, secondo il filosofo francese, non può essere provata razionalmente: può solo essere oggetto di una scommessa fortuita. In questa ipotetica scommessa, la decisione saggia, per Pascal, è scommettere sull’esistenza di Dio, in quanto «se vincete, guadagnate tutto; se perdete, non perdete nulla»: vale la pena quindi di vivere come se Dio esistesse, perché anche se così non fosse avremmo perso davvero niente, mentre potremmo vincere la vita eterna. In modo simile, il Basilisco di Roko ci spingere a “credere” e agire per realizzare una futura IA super potente così da non rischiare di essere puniti da essa in futuro. Visto che stiamo parlando di tecnologie umane e non speculazioni metafisiche, è evidente quanto questo pseudo-esperimento mentale, questo “salto della fede” tecnico porti alle alle estreme e paradossali conseguenze le idee della Singolarità e faccia emergere l’aspetto para-religioso di queste teorie.

Il Basilisco di Roko è una teoria esagerata e bizzarra, poco credibile, che però ha influenzato e colpito la sottocultura online legata all’idea della Singolarità, diventando una sorta di mito oscuro. Dovremmo invece tagliare la testa a questo fantomatico Basilisco, che simboleggia il peggior atteggiamento possibile verso il progresso tecnologico, per affrontare la questione della IA con materialismo e precisione, esorcizzando fantasie e guardando la realtà tecnica di oggi.

L’importanza di guardare la macchina

È troppo presto per cedere all’incantamento illusorio. Più che un radicalmente altro, abbiamo davanti uno sproporzionalmente altro. Troppi dati, troppe elaborazioni, troppo poco tempo. Una sproporzione che diventa sempre più insostenibile nonostante le corporation del settore tech facciano il possibile per non far emergere questo fattore, come il recente caso Timnit Gebru ha dimostrato ancora una volta. Questo è il movimento che va fatto per guardare negli occhi il complesso tecnologico che sta crescendo.

Invece che riferimenti a Skynet o a 2001: Odissea nello Spazio, proviamo a cercare nuove metafore in altri campi della tecnica. Un esempio in questa direzione è il lavoro di Matteo Pasquinelli e Vladan Joker nel progetto ‘Nooscope’, rilasciato nel 2020 sotto l’egida del KIM Institute di Karlsruhe e dello SHARE Lab. ‘Nooscope’ è una parola che unisce due etimi del greco antico: nous, pensiero o conoscenza, e skopein, che significa esaminare. Pasquinelli e Joker fanno proprio questo: esaminano un regno della conoscenza, quello delle IA, attraverso l’accostamento con le scoperte dell’ottica.

Per Pasquinelli e Joker l’IA è “uno strumento di ingrandimento della conoscenza che aiuta a percepire le caratteristiche, modelli e correlazioni attraverso vasti spazi di dati al di fuori della portata umana”. Questa definizione, concisa ed efficace, secolarizza l’idea che ci siamo fatti di Intelligenza Artificiale. In questo momento storico le IA sono esattamente questo: strumenti conoscitivi basati su complessi modelli statistici, che compiono semplificazioni e portano ad errori prospettici. È proprio in questo senso che le IA sono simili a strumenti ottici come cannocchiali e microscopi: ci fanno vedere di più, ci fanno vedere meglio ma quello che ci appare sarà sempre filtrato attraverso le loro particolari lenti. E come i molatori e gli ottici del XVI secolo, tra cui c’era anche Baruch Spinoza, i programmatori, i designer e gli ingegneri di oggi decidono la forma, lo spessore e la misura di queste lenti, tramite le quali osserviamo sempre più spesso il nostro mondo. Una tale visione materialista della questione riporta le discipline che si occupano di IA nella traiettoria dell’impresa scientifica:

“Le scienze reali, a poco a poco, hanno cominciato a lavorare attraverso un apparato capace di registrare sensazioni che andavano ben oltre la scala e la portata dell’umano. La scienza divenne non solo un modo di registrare oggettivamente ciò che il soggetto percepisce, ma anche di registrare ciò che un soggetto non potrebbe mai percepire: scale molto al di sotto della molecola o al di sopra del sistema solare; tempi più veloci anche del pensiero, o epoche miliardi di anni prima che il soggetto percepente — prima di questa unica vita che conosciamo — esistesse”

Come sono composte allora queste lenti? I modelli di machine learning si articolano in:

“un oggetto da osservare (set di dati di addestramento), uno strumento di osservazione (algoritmo di apprendimento) e una rappresentazione finale (modello statistico). […] Proseguendo con l’analogia dei mezzi ottici, il flusso di informazioni del machine learning è come un fascio di luce che viene proiettato dai dati di addestramento, compresso dall’algoritmo e diffratto verso il mondo dalla lente del modo statistico.”

Lo studio di Nooscope ha il grande merito di riportare con i piedi per terra il mito ideologico delle IA. Eppure, per quanto funzionali, gli attuali sistemi di IA hanno dimostrato di avere bias razziali basati sulla composizione del loro dataset, hanno continuato a perpetuare le ineguaglianze del sistema carcerario e occupazionale e molto altro ancora. È proprio attraverso l’esame di questi angoli bui che il progetto Nooscope fa emergere maggiormente le caratteristiche intrinseche di questo modello conoscitivo.

Come diceva il filosofo francese Paul Virilio:

“Quando si inventa la nave, si inventa anche il naufragio; quando si inventa l’aereo, si inventa anche l’incidente aereo; Ogni tecnologia porta con sé la propria negatività, che viene inventata contemporaneamente al progresso tecnico.”

Le lenti distorte e imperfette degli strumenti statistici e computazionali che adoperiamo creano un regime di “razionalità distorta”, basato su serie crescenti di “correlazioni automatizzate”. Travestito “con l’idea patriarcale di Intelligenza Assoluta”, il mondo delle IA perpetua “un’allucinazione statistica” che mette in luce determinati pattern, escludendone molti altri. Per esempio, i sistemi di classificazione che usano il machine learning sono incredibilmente deboli nel riconoscere le anomalie, specialmente quando appaiono per la prima volta. Ciò può essere un grave problema per gli algoritmi che gestiscono la guida autonoma che potrebbero non riconoscere un oggetto inedito che si presenta davanti a loro.

Parlando di sistemi di guida automatica, è importante prestare attenzione alle considerazioni del Vice Presidente di Facebook e guru delle IA a Palo Alto, Yann LeCun, sottolineate da Pasquinelli e Joker. LeCun ha spiegato che i sistemi di apprendimento profondo e le reti neurali più che simulare l’intelligenza, simulino la percezione. Rispetto alle credenze più diffuse, questo è un vero colpo di scena. Quando pensiamo a software di traduzione automatica come DeepL intuitivamente crediamo che essi “comprendano” in qualche modo i meccanismi della lingua umana o del significato di ciò che diciamo. Le macchine invece stanno percependo il nostro linguaggio attraverso il riconoscimento di pattern e regolarità che hanno imparato attraverso processi di apprendimento profondo. Oltre a rappresentare una svolta teoretica importante, questa idea rivela la fallacia di molta critica sul tema: persino quando i costruttori delle macchine ci dicono cosa stanno facendo, continuiamo compulsivamente ad illuderci che il destino delle tecnologie segua il flusso delle nostre cyber-fantasie.

E quanto queste fantasie siano ancora immature, ce lo ribadisce la realtà materiale del mondo del lavoro. Mentre nei circoli intellettuali si sogna (o addirittura si pretende) un futuro di piena automazione, l’avanzata delle macchine pseudo-intelligenti finisce per nascondere ancora di più le meccaniche di questo sfruttamento delocalizzato 3.0. Pensiamo al Mechanical Turk, la piattaforma di crowdsourcing di Amazon, dove circa 500’000 persone si contendono ogni giorno lo svolgimento di mansioni ripetitive, come il data tagging, la categorizzazione di immagini, video, testi etc. attraverso cui le macchine arrivano a “percepire” e organizzare questi flussi di dati. Amazon li chiama, con un’ironia e uno scarso senso del pudore, “Human Intelligence Tasks”, quasi a canzonare chi crede che l’Intelligenza Artificiale sia davvero intelligente e davvero autonoma dallo sforzo umano. Ben lontano dai sogni della Singolarità, è la realtà del lavoro dei Mechanical Turk, unita alla grande disponibilità dei dati, ad aver permesso i maggiori progressi nelle tecniche algoritmiche. Il dataset ImageNet, contenente più di 14 milioni di immagini, catalogato attraverso il marketplace di Amazon, è servito per allenare con successo i migliori algoritmi per il riconoscimento di immagini.

La responsabile del progetto L. Fei-Fei ha definito “un dono divino” il lavoro dei 49’000 impiegati che hanno taggato le immagini sulle quali si allenano gli algoritmi. ImageNet ha superato in scala tutti i precedenti database e ha settato lo standard per altri immensi dataset come Medical ImageNet o MusicNet. Come dichiarato dallo scienziato Alexander Wissner-Gross: “I dataset — non gli algoritmi — potrebbero essere il fattore chiave che limita lo sviluppo dell’intelligenza artificiale a livello umano”. Che mantenere questi immensi dataset abbia un impatto ambientale notevole, non sembra interessare nessuno degli addetti ai lavori (tranne Timnit Gebru).

Un’ultima curiosità: il nome Mechanical Turk deriva dal Turco Meccanico, celebre automa costruito dall’inventore Von Kempelen per Maria Teresa d’Austria. Il Turco Meccanico giocava a scacchi automaticamente, lasciando di sasso mezza Europa: nessuno capiva che l’automa in realtà nascondeva un uomo al suo interno. Fu Edgar Allan Poe a rivelare la verità dopo un’attenta indagine e ad infrangere queste prime fantasie tecnofile. Del resto, questo è anche lo scopo del progetto Nooscope: “esporre la stanza nascosta del Turco Meccanico aziendale e illuminare il lavoro invisibile della conoscenza che fa apparire ideologicamente viva l’intelligenza delle macchine.” Le proiezioni fantascientifiche, i miti del Basilisco finiscono per nascondere la questione del Turco Meccanico e gli altri problemi del presente.

Un lavoro come il Nooscope dissolve la cortina ideologica e diventa così uno strumento di resistenza epistemica. Altri studi aspettano di essere scoperti e discussi così da inventare una riorganizzazione di questo campo del sapere. Un divenire-minore delle tecnologie digitali, una resistenza algoritmica che sia arma degli oppressi, una tecnoscienza organizzata dalla prospettiva del lavoro e non del capitale, sono le nostre prospettive future. Abbiamo davanti macchine più umane di quanto ci piace ammettere: il compito di riempirle di magia è soltanto nostro.